[IA & Communication] Thomas Solignac (Golem.ai ) : « Analyser le langage humain est très difficile pour une machine »

Dans la famille « buzzword » de la communication et du marketing, l’intelligence artificielle (IA) figure clairement sur le podium des sujets les plus débattus. Martingale infaillible et inéluctable pour les uns, promesse survendue pour d’autres, relégation de l’humain au profit d’algorithmes auto-apprenants pour quelques autres, cette technologie émergente n’en finit pas d’alimenter la chronique et de soulever des questions pertinentes comme des mythes abusifs. Encore absconse pour beaucoup de professionnels, l’IA est souvent mise à toutes les sauces. Pour faire le point en toute clarté et pondération, le Blog du Communicant a interviewé Thomas Solignac. Président et co-fondateur de Golem.ai, une jeune pousse techno qui développe des interfaces de langage naturel entre l’Homme et la machine, il est au cœur des innovations qui vont remodeler la communication, le marketing et la relation client.

Avant de lancer Golem.ai en mars 2016, Thomas Solignac était déjà tombé dans la marmite de l’intelligence artificielle. Etudiant à l’Epitech, une école d’informatique réputée à Paris, il a fait partie du laboratoire d’IA de cette dernière tout en participant à une association de robotique (1). Pour autant, le jeune futur entrepreneur qu’il va devenir, ne se contente pas de brasser les algorithmes et les lignes de code pour concevoir des logiciels intelligents. En effet, il se passionne également pour une discipline qu’on pourrait situer aux antipodes d’un cursus informatique : la philosophie pour laquelle il suit en parallèle des cours à distance à la faculté de Nanterre. De cette hybridation linguistique entre informatique et sémantique, il est naturellement arrivé à travailler en profondeur sur l’interfaçage des relations et des conversations en langage naturel entre l’Homme et la machine. A l’heure où les enceintes vocales connectées de Google, Apple et Amazon font irruption sur le marché, Thomas Solignac anime de surcroît des conférences mensuelles baptisées « AI & Society » où l’intelligence artificielle est abordée de concert sous les angles technologiques, sociétaux et économiques. Raison de plus pour l’interroger sur ce que l’IA apporte (ou pas) pour la communication et le marketing.

L’intelligence artificielle est devenue de toute évidence un thème d’envergure à tel point que le célèbre mathématicien et député LREM Cédric Villani a rendu en mars 2018 un rapport prospectif et stratégique sur le sens à donner à cette technologie. Paradoxalement, cette dernière reste encore flou en termes de compréhension et de perception pour nombre de personnes. En préambule de cet entretien, pourriez-vous tracer les grandes lignes de ce que recouvre exactement la notion d’intelligence artificielle ?

Thomas Solignac : L’IA, c’est l’ensemble des théories et techniques qui visent à la création ou simulation d’intelligence. C’est donc généralement de l’artificiel par sa nature informatique (on construit un logiciel), et de l’intelligence dans la mesure où ça résout un problème. Il ne faut pas trop mettre sur un piédestal la notion d’intelligence. Bien que ce soit sujet à discussion, on définit ici l’intelligence par la capacité à résoudre un problème, au sens large.

Thomas Solignac : L’IA, c’est l’ensemble des théories et techniques qui visent à la création ou simulation d’intelligence. C’est donc généralement de l’artificiel par sa nature informatique (on construit un logiciel), et de l’intelligence dans la mesure où ça résout un problème. Il ne faut pas trop mettre sur un piédestal la notion d’intelligence. Bien que ce soit sujet à discussion, on définit ici l’intelligence par la capacité à résoudre un problème, au sens large.

Dans les faits, on emploie “intelligence artificielle” pour parler des logiciels qui interviennent d’une manière qu’on pensait jusque-là réservée aux Hommes. Cette définition, jamais formulée clairement mais populaire, montre que la définition de l’IA est glissante. Il y a beaucoup de problèmes qui étaient considérés comme relevant de l’IA il y a quelques années, que l’on relègue aujourd’hui au rang d’algorithme. Il faut peut-être y voir une blessure narcissique ! (2). Les choses qui nous paraissent complexes, qui occupent beaucoup de notre temps ou que l’on ne sait pas comment résoudre, se révèlent parfois simples à faire traiter par un logiciel.

Cela explique aussi pourquoi certaines techniques d’IA comme le Machine Learning jouissent d’une meilleure presse à cet égard. Ce sont des algorithmes à tendance boite-noire, difficiles à comprendre, qui sont largement mystifiés d’une représentation ésotérique. L’idée que l’IA puisse avoir des capacités intellectuelles semblables aux nôtres par une approche mystérieuse semble plus acceptable. Dans le fond, la différence entre “algorithme” et “intelligence artificielle” n’est donc que culturelle.

Dans le but de résoudre des problèmes de plus en plus complexes, l’IA va appeler un ensemble de disciplines variées. Il s’agit de s’inspirer de ces domaines, éventuellement les croiser, mais aussi plus largement de questionner la place de l’IA et son impact. Ainsi, on retrouve naturellement tout ce qui est relatif à l’ingénierie informatique, mais aussi les sciences cognitives, la neurologie, la psychologie, la sociologie, la linguistique, la philosophie, l’éthique etc.

L’IA est un prolongement naturel de l’informatique, dans son objectif d’automatisation et d’assistance de l’humain. En revanche, elle se différencie par la grandissante prépondérance de son intervention dans l’environnement humain. Ce positionnement symbolique saute aux yeux lorsque l’on évoque les voitures autonomes par exemple. L’IA va devoir parfois prendre la décision de sauver une personne plutôt qu’une autre. La différence entre l’IA et l’humain face à un accident, c’est que le comportement de l’IA est défini à l’avance, plus ou moins clairement, dans son code. En somme, on formalise un système qui a droit de vie ou de mort sur les individus (3). Plus que de l’édition logicielle, c’est une prise de position philosophique (grille d’analyse) et éthique (qu’est-ce qui est le mieux ?).

Vous avez cofondé Golem.ai en mars 2016 dans la foulée de vos travaux estudiantins à l’Epitech sur une technologie de langage naturel dont l’objectif était de permettre à des utilisateurs de formuler directement des requêtes orales et/ou écrites à des logiciels et des appareils connectés, des robots, etc. En retour, ceux-ci doivent être capables grâce à l’intelligence artificielle de s’adapter à leur interlocuteur en intégrant des contextes linguistiques, idiomatiques et culturels. Aujourd’hui, quelles opportunités concrètes offre Golem.ai à des professionnels de la communication et du marketing ?

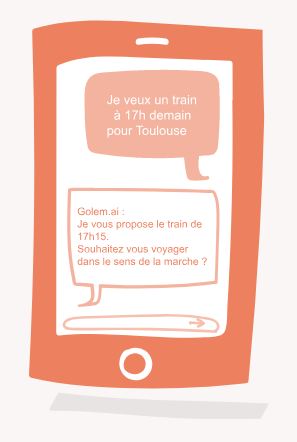

Thomas Solignac : Golem.ai permet d’automatiser ou assister les tâches dans lesquelles il y a du langage humain qui intervient. En particulier, tout ce qui est relatif à la relation client. Un domaine que l’on commence tout juste à populariser dans les entreprises, c’est le traitement automatique du langage humain. En somme, jusque-là, les logiciels ne pouvaient pas intervenir sur les flux de langage (mails, téléphone, etc). Analyser le langage humain est très difficile pour une machine.

Thomas Solignac : Golem.ai permet d’automatiser ou assister les tâches dans lesquelles il y a du langage humain qui intervient. En particulier, tout ce qui est relatif à la relation client. Un domaine que l’on commence tout juste à populariser dans les entreprises, c’est le traitement automatique du langage humain. En somme, jusque-là, les logiciels ne pouvaient pas intervenir sur les flux de langage (mails, téléphone, etc). Analyser le langage humain est très difficile pour une machine.

D’un autre côté, la relation client reste un sujet lourd de beaucoup d’entreprises : c’est une relation par le langage (oral ou écrit), difficilement automatisable/assistable. Ces usines à gaz sont une douleur de par la nature répétitive et massive, et tout à la fois, le sujet de la relation client devient un enjeu de plus en plus fort. Les clients ne tolèrent plus l’attente, le manque de formation des opérateurs, devoir dépendre des heures d’ouverture, etc…

Sur la vue d’ensemble de la transformation numérique des entreprises, les plateaux opérateurs sont un point mort. C’est l’arrivée de la compréhension automatique du langage humain qui va permettre une évolution de ces métiers. Deux grandes solutions vont venir bouleverser les méthodes :

- D’abord, celui de l’assistance (4). Golem.ai analyse les demandes entrantes, et propose à l’opérateur les informations à répondre, ou lui prépare l’action à effectuer si confirmation. Il peut s’agir d’emails auxquels un texte tout prêt de réponse va être généré, mais aussi de propositions qui s’affichent au fur et à mesure que la personne parle au téléphone.

- Une deuxième possibilité est l’automatisation complète. On met à disposition des clients un agent conversationnel (ou “chatbot”), qui répond 24/7 aux demandes des clients.

Ces deux optiques sont très différentes. L’assistance permet de conserver 100% des services proposés, là où un agent conversationnel ne peut pas remplacer certaines tâches où l’entreprise a besoin d’un humain qui prenne la responsabilité de l’action, ou bien encore trop complexes à formaliser. Aussi, l’assistance permet de conserver une relation empathique, et une supervision continue de la relation client.

L’agent conversationnel est plus limité donc, mais il a la grande qualité d’être disponible 24/7. Et même si l’assistance augmente considérablement la vitesse de traitement des demandes, l’agent conversationnel ne demande aucune ressource humaine pour fonctionner, quel que soit le nombre de demandes simultanées. Bien sûr, on peut aussi adopter une approche mixte, dans laquelle l’opérateur intervient s’il est disponible, lorsque l’agent conversationnel n’a pas satisfait le client. Cette transformation va avoir de nombreux effets positifs :

L’agent conversationnel est plus limité donc, mais il a la grande qualité d’être disponible 24/7. Et même si l’assistance augmente considérablement la vitesse de traitement des demandes, l’agent conversationnel ne demande aucune ressource humaine pour fonctionner, quel que soit le nombre de demandes simultanées. Bien sûr, on peut aussi adopter une approche mixte, dans laquelle l’opérateur intervient s’il est disponible, lorsque l’agent conversationnel n’a pas satisfait le client. Cette transformation va avoir de nombreux effets positifs :

- Augmentation de la satisfaction client

- Diminution de la pénibilité et du turn-over dans les services clients

- Changement d’échelle à moindre coût

Golem.ai va permettre que cette approche soit sereine et aisée. Grâce à des algorithmes qui ne nécessitent pas d’entraînement, on va obtenir des résultats fiables rapidement. Une fois qu’on a construit la configuration (on donne à Golem.ai la fiche de poste formalisée de l’opérateur), il est facile de traduire cette configuration dans d’autres langues, et donc d’internationaliser l’outil.

Les algorithmes de Golem.ai sont explicables (5) et donc auditables en profondeur. Dans une époque où les algorithmes sont souvent des boites-noires (Machine Learning) on propose un contre-pied en termes de confiance. Une confiance qui vient aussi de la capacité de Golem.ai à être installé chez un client ou dans un objet connecté, sans besoin de connexion internet. C’est ce placement tout particulièrement adapté au monde industriel qui fait de Golem.ai un acteur tout particulier de la transformation des entreprises par les technologies de compréhension du langage humain.

Le langage naturel humain est d’une grande complexité. Quelle que soit la langue considérée, il y a toujours des subtilités sémiologiques, des variantes linguistiques et orthographiques selon les régions ou les pays, des mots de vocabulaire à la mode, etc. Même si une langue est codifiée via les règles grammaticales, elle n’est pas figée et évolue au fil du temps à la différence des écritures mathématiques et des codes informatiques qui certes peuvent s’améliorer mais selon une logique systématique. D’où l’extrême difficulté de faire se comprendre une machine et un humain lors d’un échange verbal ou écrit. Quels sont les défis à relever dans le traitement automatique des langages humains par une intelligence artificielle ?

Thomas Solignac : Le langage est parfois ambigu pour des humains. Pour une machine, le langage humain est carrément un enfer ! Une simple phrase contient une quantité délirante d’informations, et certaines ne sont interprétables qu’à la lumière de circonstances. On pense bien sûr aux informations inhérentes à la phrase, comprendre à quoi fait référence un mot, etc. Mais on oublie aussi la pragmatique par exemple ; “Tu as l’heure ?” n’appelle pas “oui” (qui serait une réponse à une analyse uniquement sémantique) mais bien “11h37” (une réponse faisant appel à une analyse dite pragmatique). Plus largement, il y aussi toutes les informations culturelles ; le niveau de langage, le vocabulaire (y compris l’argot) les sous-entendus, les métaphores, l’ironie, etc.

Thomas Solignac : Le langage est parfois ambigu pour des humains. Pour une machine, le langage humain est carrément un enfer ! Une simple phrase contient une quantité délirante d’informations, et certaines ne sont interprétables qu’à la lumière de circonstances. On pense bien sûr aux informations inhérentes à la phrase, comprendre à quoi fait référence un mot, etc. Mais on oublie aussi la pragmatique par exemple ; “Tu as l’heure ?” n’appelle pas “oui” (qui serait une réponse à une analyse uniquement sémantique) mais bien “11h37” (une réponse faisant appel à une analyse dite pragmatique). Plus largement, il y aussi toutes les informations culturelles ; le niveau de langage, le vocabulaire (y compris l’argot) les sous-entendus, les métaphores, l’ironie, etc.

A ce stade, les IA peinent sur la plupart de ces sujets. Il semblerait qu’au-delà d’une question de formalisation du langage, il y ait une masse d’information colossale à prendre en compte. Des informations qu’on ne peut pas deviner. Seuls, les enfants les découvrent et les adultes aussi au fur et à mesure. Des informations qui changent, parce que le langage commun change, et que le réel change.

Ce qui fonctionne le mieux est de spécialiser les IA pour certaines situations. On obtient dans cette optique de bons résultats. Il faut comprendre que le langage est un reflet de l’esprit. Etre capable de créer une IA qui comprend tout le langage humain, en profondeur, c’est probablement déjà de l’intelligence artificielle générale.

Dans le domaine de la communication et du marketing, on assiste depuis environ deux ans à l’essor incontestable des agents conversationnels communément appelés chatbots. On ne compte plus les marques qui recourent à ces outils pour dialoguer avec leurs consommateurs sur les sites Web et les applications mobiles. Pourtant, rares sont encore les expériences vraiment convaincantes. En 2017, Thomas Gouritin, un expert du secteur, a publié un décapant livre blanc où il a testé une cinquantaine de chatbots. Il en résulte qu’on est souvent loin du compte et des promesses mirifiques où ces bots nourris à l’IA peinent à satisfaire. Quels sont les critères indispensables à intégrer lorsqu’on envisage la création et l’intégration d’un chatbot dans un dispositif de communication et quelles sont les vraies limites actuelles ?

Thomas Solignac : Le chatbot a déçu pour deux raisons majeures : un déroulé technologique peu mature et une optique plus “chat” que “bot”. Aujourd’hui, les technologies de compréhension du langage humain (“NLU”) se sont popularisées, mais avec une optique quasiment identique pour tous les acteurs. Cette optique, c’est d’amasser des phrases d’exemples par milliers, pour que la technologie reproduise statistiquement les comportements voulus. On obtient du résultat, péniblement, avec la nécessité de mobiliser des ressources importantes pour cet entraînement. Il faut bien imaginer que ce processus est nécessaire à toute modification du contexte d’utilisation du chatbot ; ajouter une fonctionnalité, la modifier, le traduire dans une nouvelle langue…

Thomas Solignac : Le chatbot a déçu pour deux raisons majeures : un déroulé technologique peu mature et une optique plus “chat” que “bot”. Aujourd’hui, les technologies de compréhension du langage humain (“NLU”) se sont popularisées, mais avec une optique quasiment identique pour tous les acteurs. Cette optique, c’est d’amasser des phrases d’exemples par milliers, pour que la technologie reproduise statistiquement les comportements voulus. On obtient du résultat, péniblement, avec la nécessité de mobiliser des ressources importantes pour cet entraînement. Il faut bien imaginer que ce processus est nécessaire à toute modification du contexte d’utilisation du chatbot ; ajouter une fonctionnalité, la modifier, le traduire dans une nouvelle langue…

Or, n’oublions pas que le chatbot non seulement doit pouvoir améliorer sa capacité de compréhension au fur et à mesure, mais aussi être capable de répondre à des demandes récurrentes que l’on n’avait pas prévues. En somme, ce n’est pas un objet fixe, il doit évoluer :

- Évoluer avec le langage des utilisateurs (argot, etc)

- Évoluer avec les nouvelles demandes qui apparaissent

- Évoluer avec le métier (transformation des services, etc.)

Aujourd’hui, faire évoluer un chatbot est encore pénible. D’autre part, on a survendu un aspect fun, ludique et anthropomorphique du chatbot. Il raconte des blagues, a des émotions, … etc. Il va sans dire que c’est du “bullshit” (6). Si ce n’était pas suffisamment clair jusque-là, il convient de préciser qu’à ce stade de notre compréhension de l’IA, l’anthropomorphisme ne pourra jamais être qu’un simulacre. Les IA n’ont pas d’émotions. On leur donne simplement des manières de les mimer.

Aujourd’hui, faire évoluer un chatbot est encore pénible. D’autre part, on a survendu un aspect fun, ludique et anthropomorphique du chatbot. Il raconte des blagues, a des émotions, … etc. Il va sans dire que c’est du “bullshit” (6). Si ce n’était pas suffisamment clair jusque-là, il convient de préciser qu’à ce stade de notre compréhension de l’IA, l’anthropomorphisme ne pourra jamais être qu’un simulacre. Les IA n’ont pas d’émotions. On leur donne simplement des manières de les mimer.

Tout cela est une digression à l’échelle du chatbot, dans la mesure où le “chatbot utile” passe inaperçu. Le chatbot utile c’est celui qui constitue une interface conversationnelle pour permettre d’accéder à des services ou à de l’information de manière plus efficiente et plus intuitive qu’une interface classique. L’avenir du chatbot est de ce côté-là. Ce n’est pas du “chat”, c’est un “agent conversationnel”, qui fait de la langue maternelle de chacun, le premier outil d’interaction homme-machine.

En mai 2018, vous avez lancé un questionnaire pour mieux cerner les attentes des communicants et des marketeurs envers l’IA. A vos yeux, quels sont les bouleversements les plus plausibles qui surviennent déjà ou vont survenir dans un proche avenir ?

Thomas Solignac : A ce stade on peut mettre en avant quelques tendances :

- Il y a un paradoxe entre une vraie popularité de l’IA et une très faible capacité à l’appréhender clairement

- Les domaines de l’IA les plus connus sont bien sûr les plus à la mode, alors que d’autres moins à la mode mais plus fondamentaux sont très peu connus.

- La vision des objectifs de l’IA fait apparaître très peu de consensus.

- Les chatbots sont les grands gagnants en termes d’outils déjà adoptés

- Une confiance plutôt élevée dans les capacités de l’IA, mais tout en ayant des freins organisationnels à leur mise en place effective

- Beaucoup ne savent pas le positionnement que prend leur entreprise vis à vis de l’IA

Globalement, la transition digitale des entreprises est bien plus lente que les capacités technologiques effectives. Les grands bouleversements viendront principalement de grandes entreprises concurrentes qui auront massivement et subitement empiété sur des territoires nouveaux, comme le fait régulièrement Amazon (7).

Dans le film « Her » de Spike Jonze sorti sur les écrans en 2013, le personnage principal ne parvient pas à se remettre dans son divorce. Il fait alors l’acquisition d’un système d’intelligence artificielle doté d’une voix féminine. Il va alors s’ensuivre une fascinante histoire d’amour entre l’homme et la machine qui se met à éprouver des émotions et de l’empathie. Aujourd’hui, on entend souvent dans les discours que l’AI est désormais capable de « rivaliser » avec ce qui fait le fondement même de l’humain : le sensible. Le 18 juin dernier, IBM a fait débattre sa nouvelle intelligence artificielle avec deux orateurs humains. Un mois auparavant, Google avait dévoilé Duplex, un système capable de téléphoner et de prendre des rendez-vous en dialoguant avec un humain. Jusqu’où pensez-vous que l’AI puisse se substituer à l’humain de façon équivalente en termes de communication interpersonnelle ?

Thomas Solignac : L’IA ne rivalise pas avec l’humain en termes de sensibilité. Ce que peut faire de mieux la machine à cet endroit-là, c’est simuler par la répétition. On peut faire dire à une machine “je t’aime”, on peut faire sourire un androïde, et on peut s’intéresser plus largement à comment créer un stimulus émotionnel chez un individu. Ce que “Her” nous dit, c’est que la fourberie fonctionne au moins sur certains. Le personnage principal est ici affaibli émotionnellement par sa propre situation personnelle, mais on peut questionner la capacité d’une IA à provoquer de l’attachement plus largement, sans circonstances particulières.

Thomas Solignac : L’IA ne rivalise pas avec l’humain en termes de sensibilité. Ce que peut faire de mieux la machine à cet endroit-là, c’est simuler par la répétition. On peut faire dire à une machine “je t’aime”, on peut faire sourire un androïde, et on peut s’intéresser plus largement à comment créer un stimulus émotionnel chez un individu. Ce que “Her” nous dit, c’est que la fourberie fonctionne au moins sur certains. Le personnage principal est ici affaibli émotionnellement par sa propre situation personnelle, mais on peut questionner la capacité d’une IA à provoquer de l’attachement plus largement, sans circonstances particulières.

Ces réflexions nous renvoient en permanence à la question de la singularité ; la différence entre l’IA et l’Homme n’est-elle qu’une différence de complexité ? Pourrait-on construire une machine qui ressentirait également une douleur ou un plaisir, et dont les droits seraient à considérer ? Ces questions demeurent ouvertes !

Un autre grand débat agite les communicants et les marketeurs : la combinaison de l’IA avec le Big Data et le Machine Learning. L’idée serait de disposer ainsi d’outils puissants capables de prédire la portée d’une campagne de communication, la probabilité d’un événement, de simplifier la prise de décision, etc. Tout récemment, des chercheurs de la Technical University de Dortmund en Allemagne ont profité de la Coupe du Monde de football en Russie pour présenter leurs travaux dans ce domaine. Pour prédire le vainqueur de la compétition, ils ont intégralement simulé 100 000 fois le tournoi. L’Allemagne figurait parmi les gros gagnants possibles. Or, celle-ci a été d’emblée éliminée au 1er tour ! Ne croyez-vous pas que l’on a tendance à trop en faire en matière de marketing prédictif à base d’IA ?

Thomas Solignac : Le Machine Learning et le Big Data sont des algorithmes de prédiction par répétition. Ils supposent que le futur va se produire comme l’a été le passé. Avec les bonnes données clés, on va pouvoir prédire ce qui va se passer pour la suite. Maintenant que cela est dit, les limites paraissent évidentes :

Thomas Solignac : Le Machine Learning et le Big Data sont des algorithmes de prédiction par répétition. Ils supposent que le futur va se produire comme l’a été le passé. Avec les bonnes données clés, on va pouvoir prédire ce qui va se passer pour la suite. Maintenant que cela est dit, les limites paraissent évidentes :

- Il faut choisir les données pertinentes. Quelles sont-elles ? Sont-elles suffisantes ? Les données pertinentes sont-elles accessibles ? Peut-être que la vie intime des joueurs a un rôle prépondérant sur les résultats.

- Les logiques de fond ne changent-elles pas ? En quelques années, les enjeux économiques, personnels, humains, culturels, changent. Autant de variables, de données, qu’il faudrait possiblement mettre dans la machine. Mais comment quantifier des données aussi complexes et nombreuses ?

Le duo Machine Learning + Big Data a offert des prédictions très efficaces dans certains contextes, moins d’en d’autres. La question de fond pour moi est la suivante : Veut-on répéter le passé ? Imaginons qu’on laisse le choix des recrutements à une IA par Machine Learning, cherchant à répéter les comportements de sélection effectués jusque-là. Supposons, follement, que l’IA obtient 100% de fiabilité ; les nouveaux collaborateurs sont bien ceux qu’aurait choisis un humain. On est donc en train de répéter ce qu’a toujours fait l’entreprise, avec toutes ses qualités certes, mais aussi avec ses défauts, ses biais potentiels de sexisme, racisme, et bien d’autres biais plus difficiles à repérer. Dans le fond des choses, cela fixe l’intelligence à un moment donné, c’est un frein au renouvellement et à l’amélioration de l’entreprise. Je lève un risque particulier sur cette optique-là.

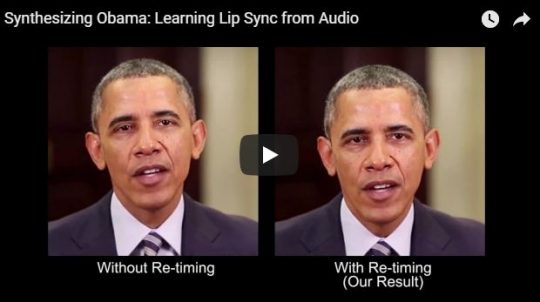

Comme toute technologie émergente, l’intelligence artificielle est susceptible d’être dévoyée à des fins nettement moins recommandables et pertinentes. En 2017, des chercheurs de l’université de Washington ont effectué une troublante expérimentation grâce à l’IA. Ils sont parvenus à faire prononcer à Barack Obama un discours qu’il n’a jamais dit grâce à un outil d’IA. Pour cela, ils ont utilisé des morceaux d’interviews sonores qui ont été rassemblés, superposés et associés à une bouche créée en image de synthèse. Selon vous qui êtes par ailleurs épris de philosophie, quelles limites éthiques doivent être anticipées et tracées pour éviter (ou du moins juguler) certaines dérives communicantes de type « fake news » ?

Thomas Solignac : C’est clairement l’enfer pour les médias. On va être en capacité de produire des fake news de plus en plus convaincantes. Dans un moment de relativisme généralisé, avec une émergence de communautés qui prennent des positions de plus en plus marginales sur des sujets importants (le vaccin par exemple), la capacité de tromper est un vrai danger. La trame de fond, c’est que le réel est de moins en moins tangible. Vérifier, prouver et sourcer, est de plus en plus difficile. Une vraie question se pose ; comment responsabiliser chacun face à l’information ?

Thomas Solignac : C’est clairement l’enfer pour les médias. On va être en capacité de produire des fake news de plus en plus convaincantes. Dans un moment de relativisme généralisé, avec une émergence de communautés qui prennent des positions de plus en plus marginales sur des sujets importants (le vaccin par exemple), la capacité de tromper est un vrai danger. La trame de fond, c’est que le réel est de moins en moins tangible. Vérifier, prouver et sourcer, est de plus en plus difficile. Une vraie question se pose ; comment responsabiliser chacun face à l’information ?

On parle aujourd’hui de post-vérité (8) ou d’ère post-factuelle. Il s’agit globalement de l’idée que la vérité n’est plus importante, ou plus au cœur des débats. Le fait serait subjectif, l’opinion subjective étant tout ce qui existe. La vérité serait donc une aberration par nature. Les théories du complot seraient le symbole par excellence de ce changement d’ère, non pas des positions qu’ils prennent, mais de la manière dont ils les défendent.

Ce primat de l’émotion sur la raison fait clairement écho à tout un vieux débat philosophique autour de la notion de vérité et de la subjectivité. On y retrouve beaucoup de problématiques liées à la rhétorique et l’épistémologie, mais aussi plus largement aux phénomènes d’influence sociale. Le paradoxe, c’est que si l’IA facilite la création de fake news, elle peut aussi grandement aider à la détecter, que ce soit des fake news video, audio (recherche d’éléments synthétiques) ou écrites (recherche de sources, etc.).

Sources

– (1) – Patrick Capelli – « Thomas Solignac simplifie les algorithmes de langage naturel » – La Tribune.fr – 26 mai 2018

– (2) – https://www.linkedin.com/pulse/lia-ne-tuera-pas-le-travail-il-est-d%C3%A9j%C3%A0-mort-michel-sasson/

– (3) – http://www.parismatch.com/Actu/Sciences/Pour-la-premiere-fois-une-voiture-autonome-a-tue-un-pieton-1482392

– (4) – https://blog.salemove.com/ai-assisted-human-chat-next-big-thing/

– (5) – https://www.decideo.fr/La-GDPR-va-elle-tuer-le-developpement-de-l-IA-en-Europe_a10100.html

– (6) – https://www.youtube.com/watch?v=Tz_8TC8woyM

– (7) – https://www.argusdelassurance.com/acteurs/amazon-se-prepare-a-debouler-dans-l-assurance-en-europe.123997

– (8) – https://fr.wikipedia.org/wiki/%C3%88re_post-v%C3%A9rit%C3%A9