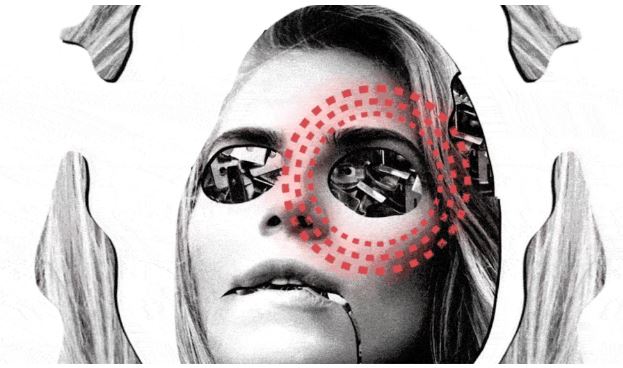

Information & Réputation : Le “deep fake video” est-il la prochaine menace pour les communicants ?

A peine vient-on d’apprendre (ou du moins essayer) à se familiariser et à repérer les « fake news » qu’il faut déjà devoir faire face à un nouveau défi informationnel : le « deep fake video ». Profitant de la popularité du format vidéo dans la consommation des médias et des réseaux sociaux ainsi que des avancées de l’intelligence artificielle (IA), ce phénomène gagne du terrain sur le Web. Il permet de diffuser des contenus audio et vidéo sciemment trafiqués mais à l’apparence encore plus crédible que les infoxs qui circulent en masse et qui constituent une arme réputationnelle de choix pour les activistes de tous bords. Arrêt sur image à propos d’une tendance qui n’est pas prête de s’estomper.

Très récemment, nombre de vidéos ont été au cœur de virulentes polémiques lors des manifestations à répétition des Gilets Jaunes. Il y eut d’abord cette séquence filmée par deux journalistes où l’on voit des individus casqués et masqués tenter d’agresser délibérément un motard de la police tombé à terre sur les Champs Elysées. Vidéo qui suscita aussitôt l’indignation mais aussi la controverse avec plus tard, la mise en ligne de plans supplémentaires montrant que la police avait fait préalablement usage de grenades lacrymogènes pour désencercler des CRS menacés par des agitateurs. Rebelote le 6 janvier où une atterrante vidéo met en scène un ancien boxeur en train de savater et cogner avec acharnement des gendarmes mobiles. Avant qu’une autre vidéo ne réplique à celle-ci en dévoilant la scène précédente où le castagneur se fait asperger de gaz lacrymo.

Point commun de toutes ces images filmées : elles sont authentiques. Le débat s’est donc essentiellement cristallisé sur le timing et le relais médiatique dont certaines auraient plus bénéficié que d’autres. Ce qui peut effectivement induire des distorsions en matière d’interprétation et de perception des faits. Et de radicaliser encore un peu plus les opinions concernant les violences qui émaillent sans cesse les défilés improvisés et destructeurs des Gilets Jaunes. Néanmoins, il existe aujourd’hui un péril informationnel encore plus grand et plus puissant : le “deep fake video”. Pour l’instant, ce phénomène d’intox reste encore cantonné dans des domaines bien précis. Il est fort à craindre cependant que celui-ci connaisse un succès grandissant auprès d’acteurs militants soucieux de capter la crédulité des publics pour mieux les mobiliser. Le risque est loin d’être neutre dans un contexte où les contenus des médias font l’objet par ailleurs d’une défiance record au sein de l’opinion publique et que les “fake news” pullulent à gogo.

Aux origines du “deep fake”

En mai 2018, une vidéo postée sur Twitter et Facebook a défrayé la chronique. Dans celle-ci, on y entendait Donald Trump déclarer à l’intention du peuple belge (1) : « Comme vous le savez, j’ai eu les couilles de retirer les USA de l’accord sur le climat de Paris. Vous devriez faire de même. Parce que ce que vous faites en Belgique est bien pire ». Immanquablement, les commentaires outragés n’ont pas manqué de fuser Outre-Quiévrain. Pourtant, même si le propos pouvait sembler crédible tant l’hôte de la Maison Blanche est coutumier des formules à l’emporte-pièce, rien n’était vrai. Il s’agissait d’une vidéo commandée par un parti politique belge, le Socialistiche Partij Anders. Avec un objectif bien précis : mobiliser pour obtenir la fermeture immédiate d’une centrale nucléaire du pays. Or, la particularité de cette vidéo apocryphe est d’avoir été réalisée grâce à un logiciel de retouche informatique qui utilise de l’intelligence artificielle pour optimiser les effets visuels et rendre l’ensemble vraisemblable aux yeux de l’audience.

En mai 2018, une vidéo postée sur Twitter et Facebook a défrayé la chronique. Dans celle-ci, on y entendait Donald Trump déclarer à l’intention du peuple belge (1) : « Comme vous le savez, j’ai eu les couilles de retirer les USA de l’accord sur le climat de Paris. Vous devriez faire de même. Parce que ce que vous faites en Belgique est bien pire ». Immanquablement, les commentaires outragés n’ont pas manqué de fuser Outre-Quiévrain. Pourtant, même si le propos pouvait sembler crédible tant l’hôte de la Maison Blanche est coutumier des formules à l’emporte-pièce, rien n’était vrai. Il s’agissait d’une vidéo commandée par un parti politique belge, le Socialistiche Partij Anders. Avec un objectif bien précis : mobiliser pour obtenir la fermeture immédiate d’une centrale nucléaire du pays. Or, la particularité de cette vidéo apocryphe est d’avoir été réalisée grâce à un logiciel de retouche informatique qui utilise de l’intelligence artificielle pour optimiser les effets visuels et rendre l’ensemble vraisemblable aux yeux de l’audience.

Ainsi se déploie progressivement ce phénomène récent plus communément appelé “deep fake”. Ce mot-valise découle de l’association de deux notions. La première est relative au “deep learning”, la technologie d’acquisition du savoir usitée par l’intelligence artificielle. La seconde se réfère aux “fake news” dorénavant tristement répandues pour manipuler les opinions. Cette combinaison vidéo (voire orale car un podcast peut être dévoyé de la même façon) consiste donc à faire dire n’importe quoi à un personnage public donné par le biais d’une technologie puissante qui permet de fondre les expressions et la gestuelle de son visage avec des mots prononcés par cette même personne mais redécoupés et agglomérés de manière totalement biaisée. Baptisée “generative adversarial network” (GAN), cette technique est le fruit du travail mis au point par un étudiant américain, Ian Goodfellow, en 2014. Son algorithme est capable de générer de nouveaux contenus audio et vidéo à partir de mêmes contenus déjà existants. Mais avec un sens radicalement différent dans bien des cas.

Des trucages à la portée de presque tous

Problème : cette technique n’est pas longtemps restée dans les tiroirs. A tel point que le site spécialisé américain The Verge a repéré (2) diverses variantes de “deep fake” qui vont du “face swap” (la substitution de visage dans une vidéo) à l’”audio deep fake” (répliquer la voix de quelqu’un en réorchestrant des propos) en passant par le “deep fake puppetry” (un visage d’acteur enregistré qui mime les points d’expression faciale d’une personne). Ce qui a donné naissance au passage d’applications au “deep fake” comme la bien-nommée FakeApp ou alors TensorFlow, un outil Open Source développé par Google et bien d’autres encore. Ce qui a largement contribué à la prolifération des usages faussaires parmi les adeptes de la bidouille informatique.

Pour Vincent Nozick, chercheur au laboratoire d’informatique Gaspard-Monge en région parisienne, l’accessibilité et la manipulabilité de ces programmes informatiques à base d’IA constituent une menace à prendre au sérieux (3) : « Ces trucages ne demandent pas de connaissances très approfondies en mathématiques, ni de matériel informatique très perfectionné ». A condition toutefois de disposer d’une base de données abondante sur la personne qui sera victime du “deep fake”. Dans le cas contraire, l’effet manipulatoire recherché peut être trop évident et par conséquent, ne pas réussir à induire le public en erreur. Il n’en demeure pas moins que les “progrès” technologiques sont patents comme le constate cette autre experte canadienne des transformations numériques dans les industries médiatiques et culturelles, Catilina Briceno (4) : « Certains développeurs prétendent actuellement qu’il faut un minimum de 14 heures de données audio et visuelles pour que les résultats soient convaincants. Avec le deep fake, on vient rehausser forcément le potentiel de fabrication de fausses nouvelles ».

Pour Vincent Nozick, chercheur au laboratoire d’informatique Gaspard-Monge en région parisienne, l’accessibilité et la manipulabilité de ces programmes informatiques à base d’IA constituent une menace à prendre au sérieux (3) : « Ces trucages ne demandent pas de connaissances très approfondies en mathématiques, ni de matériel informatique très perfectionné ». A condition toutefois de disposer d’une base de données abondante sur la personne qui sera victime du “deep fake”. Dans le cas contraire, l’effet manipulatoire recherché peut être trop évident et par conséquent, ne pas réussir à induire le public en erreur. Il n’en demeure pas moins que les “progrès” technologiques sont patents comme le constate cette autre experte canadienne des transformations numériques dans les industries médiatiques et culturelles, Catilina Briceno (4) : « Certains développeurs prétendent actuellement qu’il faut un minimum de 14 heures de données audio et visuelles pour que les résultats soient convaincants. Avec le deep fake, on vient rehausser forcément le potentiel de fabrication de fausses nouvelles ».

La propagation s’amplifie

Ces deux dernières années viennent de prouver que le “deep fake” gagne du terrain d’une part et s’améliore en termes de rendu visuel et sonore d’autre part. En 2017, c’est d’abord le site web communautaire Reddit qui s’est alarmé du nombre croissant de vidéos triturées contenant de confondants montages pornographiques avec le visage des actrices (par exemple) Emma Watson et de Reese Whitherspoon mais aussi de l’ancienne Première dame, Michelle Obama. La plateforme a même fermé des groupes de discussion où s’échangeaient les tuyaux et les applis pour fabriquer de tels trucages. D’autres réseaux variés comme Twitter, YouTube mais aussi PornHub ont été à leur tour infestés par ces mêmes vidéos trafiquées.

Ces deux dernières années viennent de prouver que le “deep fake” gagne du terrain d’une part et s’améliore en termes de rendu visuel et sonore d’autre part. En 2017, c’est d’abord le site web communautaire Reddit qui s’est alarmé du nombre croissant de vidéos triturées contenant de confondants montages pornographiques avec le visage des actrices (par exemple) Emma Watson et de Reese Whitherspoon mais aussi de l’ancienne Première dame, Michelle Obama. La plateforme a même fermé des groupes de discussion où s’échangeaient les tuyaux et les applis pour fabriquer de tels trucages. D’autres réseaux variés comme Twitter, YouTube mais aussi PornHub ont été à leur tour infestés par ces mêmes vidéos trafiquées.

Autre cas cette fois à vocation universitaire mais qui a cependant de quoi interpeler : la troublante expérimentation menée par des chercheurs de l’université de Washington en 2017. Ceux-ci sont parvenus à faire prononcer à Barack Obama, un discours qu’il n’a jamais dit grâce à un outil d’IA. Pour cela, ils ont utilisé des morceaux d’interviews qui ont été rassemblés, réorganisés et superposés sur une bouche créée en image de synthèse. Ces scientifiques ont également fait appel à l’intelligence artificielle pour les aider à associer des sons aux mouvements de bouche correspondants.

C’est d’ailleurs encore un détournement de Barack Obama qui va faire du bruit l’année suivante. En avril 2018, le site américain d’information BuzzFeed fait sensation en diffusant une vidéo d’un discours de Barack Obama qui paraît plus que vrai bien qu’il ne l’ait jamais prononcé. Et pour cause ! Il y insulte Donald en le qualifiant de “total deep shit” et d’autres noms fleuris. La voix de l’ex-président semble certes un peu plus chevrotante que la vraie. Mais un auditeur écoutant d’une oreille leste peut aisément tomber dans le piège comme celui de la vidéo belge évoquée au début de cette article.

Antidotes en vue ou pas ?

Comme à chaque fois qu’une falsification est établie, chacun se demande comment lutter efficacement contre ce fléau informationnel. Des solutions existent comme le remarquable travail de décryptage effectué par les sites des Décodeurs (Le Monde) ou de Check News (Libération) ou encore le recours à des sites qui permettent de retracer l’origine véritable de documents visuels comme Tin Eye ou Google Images. Sauf qu’avec l’émergence du « deep fake », les choses se compliquent. Chercheur au Centre de mathématiques de l’École normale supérieure de Paris-Saclay, Jean-Michel Morel pointe une caractéristique (5) : « Les vidéos mises sur Internet sont souvent de piètre qualité, car elles sont comprimées [donc dégradées, NDLR] pour être diffusées plus facilement, et il devient alors très difficile de détecter les altérations qui indiquent une manipulation ».

Photo Seth Laupus

Sommes-nous par conséquent condamnés à subir des mensonges ultra-réalistes à notre corps défendant ? La riposte tente en tout cas de s’organiser. Professeure à l’université de Lausanne (UNIL) et experte internationale en cybersécurité et cyberdéfense, Sonia Ghernaouti pense que la certification des images deviendra un « must » (6). Encore faut-il que les algorithmes de détection puissent fonctionner à plein. Sur ce point, Alan Dolhasz, chercheur spécialisé dans l’imagerie numérique à l’université de Birmingham (Grande-Bretagne) pondère largement. Pour traquer ces trucages sur Internet, les algorithmes doivent apprendre à reconnaître une tricherie. Or, celui-ci déplore (7) le « manque de bases de données de ‘deep fake » du fait de ce phénomène récent et du manque de points de référence fournis en la matière. Tout en pondérant sa vision alarmiste (8) : « La recherche dans ce domaine avance très vite. Les efforts portent sur la synchronisation de la bouche avec la parole, les mouvements des yeux ou encore le lien entre le visage et décor du fond. “Les ‘deep fake’ vont donner lieu à une course technologique entre les faussaires et ceux qui essaient de les contrer ».

Vigilance et esprit critique avant tout

Il n’empêche que la technologie ne fera pas tout (comme très souvent) pour contrer ces dérives informationnelles. En dépit des thuriféraires du logiciel qui promettent du code informatique infaillible, l’humain reste clé par ses capacités de vigilance, d’esprit critique et de mise en perspective. C’est d’ailleurs dans cette optique que s’est créée l’initiative québécoise « 30 secondes avant d’y croire ». Cette formation s’adresse à des élèves de second cycle pour les aider à faire le tri entre le vrai et le faux dans les contenus accessibles depuis Internet. Comme pour les « fake news » et la propagande en général, l’éducation est et sera toujours clé pour apprendre à ne pas gober instantanément une information et identifier le sérieux (ou pas) des émetteurs de celle-ci.

Néanmoins, le défi demeure grandissime. Entreprises comme marques et personnalités ont tout intérêt à suivre de près ce nouveau phénomène de désinformation tout en continuant à prendre la parole pour offrir des alternatives éditoriales. C’est d’autant plus crucial que l’humain, par paresse intellectuelle et/ou conviction inoxydable, a souvent plus envie de croire à ce qui étaye ses opinions quelle que soit la source. Et pire encore, surtout si celle-ci a été relayée par des proches ou des « comme moi » considérés intuitivement comme garants de la véracité du contenu (même si celui-ci est faux). Pour s’en convaincre, il suffit de se remémorer la flambée de discours fantasques et conspirationnistes qui a eu lieu dans la foulée de l’attentat de Strasbourg en décembre 2018. Beaucoup sont encore persuadés (malgré l’évidence des faits) que le gouvernement a organisé (ou encouragé) un attentat meurtrier pour briser la dynamique du mouvement des Gilets Jaunes et faire ainsi diversion. Imaginez un instant qu’une « deep fake vidéo » ait été éditée pour la circonstance. La croyance serait probablement encore plus prégnante. Raison de plus pour sortir des discours convenus et anesthésiants en matière de communication.

Sources

– (1) – Oscar Schwartz – “You thought fake news was bad? Deep fakes are where truth goes to die” – The Guardian – 12 novembre 2018

– (2) – James Vincent – “Why we need a better definition of ‘deepfake’” – The Verge – 22 mai 2018

– (3) – Sébastien Seibt – “« Deep fake » : ces trucages vidéo accusés de menacer la démocratie américaine” – France 24.com – 14 septembre 2018

– (4) – “Le deep fake repousse les frontières de la falsification” – Radio Canada – 11 août 2018

– (5) – Sébastien Seibt – “« Deep fake » : ces trucages vidéo accusés de menacer la démocratie américaine” – France 24.com – 14 septembre 2018

– (6) – Marie-Emilie Catier et Pauline Duruban – « Les « deep fakes », des vidéos truquées au fort potentiel de nuisance » – RTS Info – 29 mars 2018

– (7) – Sébastien Seibt – “« Deep fake » : ces trucages vidéo accusés de menacer la démocratie américaine” – France 24.com – 14 septembre 2018

– (8) – Ibid.

2 commentaires sur “Information & Réputation : Le “deep fake video” est-il la prochaine menace pour les communicants ?”-

-

Merci pour cet article très complet.

Le sujet est de grande importance car, derrière les aspects techniques, la propagation de fausses informations, quelqu’en soit la forme, participe d’un mouvement qui met en cause toutes les informations, y compris celles des grands médias, considérés comme orientés et manipulateurs. Le paradoxe est que l’information « informelle » apparaît comme plus crédible que le travail sérieux des journalistes professionnels.

Ce cercle vicieux pose deux problèmes : l’infobésité conduit-elle au rejet de l’information ? La remise en cause de l’information met-elle en danger la démocratie ? Dans les deux cas, malheureusement, il semblerait que la réponse soit « oui ».

Au fond du sujet, une question : l’information est-elle une croyance ? Doit-on croire en l’information ou chacun a-t-il un devoir d’y réfléchir et d’y opposer un droit à son libre-arbitre ? La remise en cause de l’information gêne les élites férues d’ordre, de rationalité, de tableaux Excel. Il est vrai que, dans communiquer, il y a une notion de persuasion, donc d’intention, de volonté d’influence. Communiquer, c’est donc aussi, s’opposer à la variété des cibles et faire front aux nuances de convictions de chacun.

Pour reprendre votre sujet, la tromperie existait déjà dans l’écrit : la presse d’opinion n’a jamais hésité à utiliser l’information dans le but d’appuyer leur vision. La certification présente donc une garantie, mais risque de gêner la liberté d’expression et, de toute façon, elle sera perçue par les opposants comme une preuve de plus de la manipulation publique.

Une régulation se mettra en place, mais plus sur le modèle de l’appropriation de toutes les grandes évolutions. Les opinions s’adaptant d’elles-mêmes par l’apprentissage.

Devoir de vigilance donc, devoir d’alerte, mais confiance et compréhension que la vérité des uns n’est pas celles des autres.

Merci Pascal

Vous avez sûrement mis le doigt sur un point crucial qui alimente aujourd’hui cette pandémie de fake news : le refus d’admettre que vérité des uns n’est pas celle des autres. Et plus que cela, la promotion de discours binaires qui rassurent celles et ceux qui n’ont pas envie de comprendre ou de faire l’effort de comprendre. Par comprendre, j’entends écouter d’autres avis et faire sa propre synthèse. Nombreux sont celles et ceux qui préfèrent s’enfermer dans ce qui les conforte dans leurs opinions. Quitte à usiter de « fake news » pour marteler et tout en surfant sur la défiance globale

Les commentaires sont clos.