Deep fake & IA : Communicants et marketeurs, cessons immédiatement de jouer avec le feu !

En matière de création visuelle et de trucages audio, les logiciels d’IA générative progressent à une cadence stratosphérique. Le niveau de réalisme atteint est tel qu’il faut un œil particulièrement aiguisé pour détecter qu’il s’agit en fait d’un contenu fictif assemblé grâce à l’intelligence artificielle. Ces prouesses technologiques sont de plus en plus prisées par les concepteurs de campagnes virales pour des marques, des entreprises ou des partis politiques. Problème : à force de brouiller les lignes dans un univers informationnel lui-même déjà sérieusement infecté par les « fake news » et les vidéos « deep fake », cette propension joue dangereusement avec les lignes de l’éthique et de la salubrité éditoriales. Il est encore temps de se reprendre en main pour éviter un chaos cognitif.

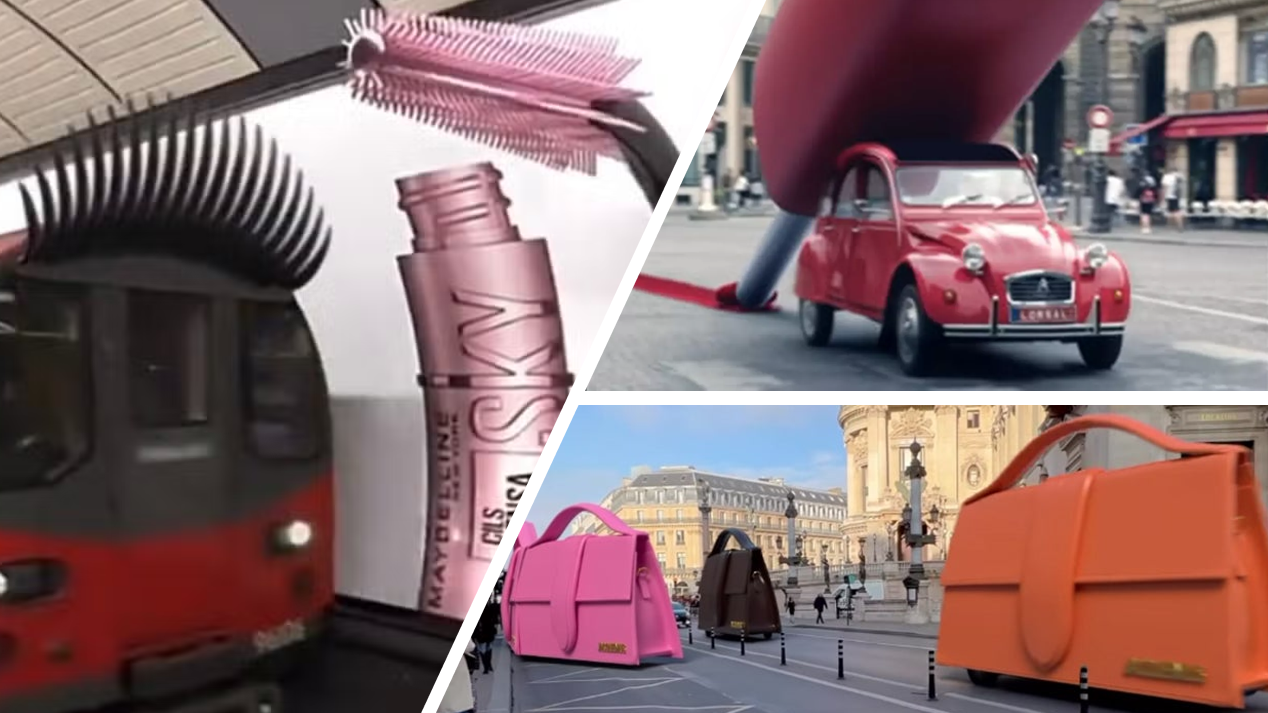

Une rame de métro londonien qui se met du mascara grâce à une brosse à cils géante, un gratte-ciel new-yorkais qui s’orne d’un pinceau de maquillage tout autour de sa façade, des sacs à main bigarrés géants qui circulent place de l’Opéra à Paris tandis qu’une mythique 2CV étend du vernis à ongle rouge sur la chaussée … Je vous rassure, ces scènes ne proviennent pas de résidus de champignons hallucinogènes mais de petits films vidéo concoctés pour des marques de cosmétiques et de mode. Objectif : créer la surprise, interpeler et rendre viral ces images sur les réseaux sociaux. Bienvenue dans la communication « made in » IA.

Et maintenant, le « fake out of home » !

Depuis 2023, ce genre de vidéos entièrement générées par IA rencontre un vif succès chez les annonceurs. Au lieu de faire du street marketing avec de coûteuses installations (qui prennent de surcroît un temps de conception bien plus important que la durée même de la campagne de communication), de nombreuses marques se tournent vers des publicités hyperréalistes qui mêlent décors réels et animations virtuelles. Ce nouveau terrain de jeu créatif porte même un nom : le « fake out of home ».

Ian Padgham est l’un de ces créateurs en vogue qui s’attache à jongler avec les dimensions parallèles à l’instar de Keanu Reeves sautant de monde en monde dans le célèbre film de science-fiction Matrix. A ses yeux, ce type de communication va s’imposer dans la palette des communicants et des marketeurs (1) : « J’appelle ce style de publicité FOOH, ou Faux out of home, car le concept est de montrer une campagne publicitaire qui pourrait exister dans la vie réelle mais qui est purement en 3D. À l’époque où nous vivons et partageons tout en ligne, je pense que les campagnes FOOH pourraient devenir la plus grande tendance de la publicité en ligne ».

Cet enthousiasme créatif n’est pourtant pas sans poser de sérieuses questions. Avec cette hybridation du réel et du virtuel dans des films (ou des visuels) d’un confondant réalisme, on entre dans une zone grise qu’il conviendrait de structurer avec des règles strictes. Première observation commune à l’immense majorité de ces campagnes : à aucun moment, il n’est indiqué que la vidéo est une création fictive à base d’intelligence artificielle. Rien que l’insertion de cet avertissement envers le public suffirait déjà à résoudre une partie du problème. Les documentaires et les reportages TV qui recréent des scènes sur un sujet donné prennent bien le soin de préciser à chaque fois qu’il s’agit d’une reconstitution. Pourquoi n’en serait-il pas de même pour ces créations marketing ?

Vers la grande confusion entre vrai et faux ?

Cognitivement, il est particulièrement périlleux (et irresponsable) de s’amuser à constamment brouiller la perception des audiences ciblées. Le coup marketing ne peut pas justifier à lui seul qu’on évacue cette épineuse question. Si tout finit par se confondre, les repères informationnels (déjà sérieusement malmenés par les infoxs des complotistes et propagandistes patentés) vont finir par exploser laissant tout à chacun dans un désordre indescriptible où l’on ne saura même plus distinguer le vrai du faux. Directrice de la stratégie chez McCann London, Mel Arrow avance une posture possible pour tenter de ne pas sombrer dans cette dérive parasitaire (2) : « Make it real or make it spectacularly fake. But nothing in between ». En d’autres termes, soit on réalise pour de vrai l’effet recherché, soit on s’arrange pour qu’on comprenne clairement que l’astuce de communication repose sur du fictif pur. A voir !

Ce flou communicant n’est en tout cas plus tolérable à l’heure où les « fake news » ont la peau dure et pervertissent suffisamment gravement la lecture et la compréhension de la réalité. Jouer avec le faux ou le vraisemblable a déjà été pratiqué dans le passé et ceci sans recours à l’IA. Souvenons-nous notamment de la campagne Carambar en 2013. Grâce à un dispositif qui jouait avec duplicité sur la crédulité des internautes (qui ont eux-mêmes tendance à croire plus spontanément ce qui circule sur Internet qu’ailleurs), la friandise a réussi à faire croire qu’elle allait bientôt mettre fin à ses célèbres blagues au verso de ses emballages. L’exposition médiatique fut retentissante jusqu’au moment où la supercherie fut enfin révélée (lire à ce sujet le billet du Blog du Communicant).

L’ère du canular est derrière nous

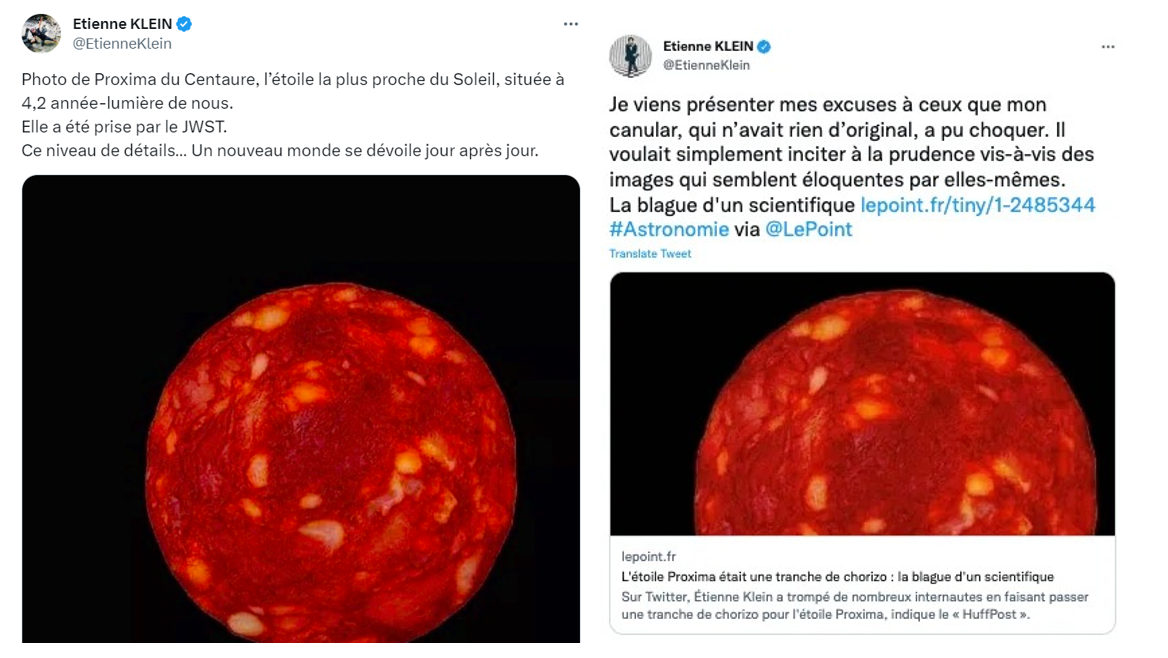

Si les canulars du 1er avril ont longtemps été marrants et bluffants, c’est parce qu’ils étaient diffusés à un moment bien précis et dans un contexte où ne circulaient pas autant de contenus apocryphes et falsifiés. D’ailleurs aujourd’hui, bien moins nombreux sont les médias à pratiquer encore le genre tant parfois la réalité dépasse la fiction ou que les « fake news » prennent le dessus sur le réel. Même les blagues les plus sincères et sans arrière-pensées peuvent être mal interprétées. C’est la mésaventure qui est survenu au physicien et philosophe des sciences Etienne Klein. Le 31 juillet dernier, il publie sur son compte Twitter/X une photo d’une tranche de chorizo en l’affublant de la légende suivante (3) : « Photo de Proxima du Centaure, l’étoile la plus proche du Soleil, située à 4,2 année-lumière de nous. Elle a été prise par le JWST. Ce niveau de détails… Un nouveau monde se dévoile jour après jour ».

Si d’aucuns rigolent et saisissent l’humour du scientifique du CEA, d’autres se montrent fort mécontents qu’un savant renommé se prête à ce genre de facétie qui a dupé nombre de personnes. Devant le buzz médiatique engendré, Etienne Klein rétropédale avec philosophie (4) : « Au vu de certains commentaires, je me sens obligé de préciser que ce tweet relevait d’une forme d’amusement. Apprenons à nous méfier des arguments d’autorité autant que de l’éloquence spontanée de certaines images… ».

Stop à l’abus de « deep fake »

Cette communication « borderline » n’affecte pas que les marques et les entreprises. D’autres acteurs se laissent tenter à leur tour par les possibilités technologiques puissantes qu’offre l’IA pour revisiter la réalité selon ses propres objectifs. C’est par exemple le cas de Loïc Signor, porte-parole du parti Renaissance. Le 31 décembre dernier, cet ancien journaliste a suscité un certain émoi en partageant sur son compte Twitter/X une vidéo « deep fake » de Marine Le Pen présentant ses vœux … en russe. L’intention était certes de souligner la proximité financière et idéologique de la présidente du groupe RN à l’Assemblée nationale avec le régime de Poutine. Seulement, l’intention ne fait pas raison. Si chacun commence à recourir à ce type de procédé, c’est le capharnaüm assuré où il n’est pas acquis que la démocratie sorte gagnante. Pour une fois, il serait pertinent de ne pas imiter ce qui est en train de se passer aux Etats-Unis où le camp Trump fourbit ses armes à coups de vidéos truquées et dopées à l’IA pour démolir son adversaire démocrate.

Cette communication « borderline » n’affecte pas que les marques et les entreprises. D’autres acteurs se laissent tenter à leur tour par les possibilités technologiques puissantes qu’offre l’IA pour revisiter la réalité selon ses propres objectifs. C’est par exemple le cas de Loïc Signor, porte-parole du parti Renaissance. Le 31 décembre dernier, cet ancien journaliste a suscité un certain émoi en partageant sur son compte Twitter/X une vidéo « deep fake » de Marine Le Pen présentant ses vœux … en russe. L’intention était certes de souligner la proximité financière et idéologique de la présidente du groupe RN à l’Assemblée nationale avec le régime de Poutine. Seulement, l’intention ne fait pas raison. Si chacun commence à recourir à ce type de procédé, c’est le capharnaüm assuré où il n’est pas acquis que la démocratie sorte gagnante. Pour une fois, il serait pertinent de ne pas imiter ce qui est en train de se passer aux Etats-Unis où le camp Trump fourbit ses armes à coups de vidéos truquées et dopées à l’IA pour démolir son adversaire démocrate.

Avec 41% des Français qui s’informent d’une manière ou d’une autre via les réseaux sociaux (et un pourcentage qui atteint 62% chez les moins de 25 ans) (5), il n’est pas tolérable, ni acceptable de souffler sur les braises de la confusion. Qu’il s’agisse de vendre des marques, de démonter un concurrent ou de créer le buzz à tout prix, aucun argument ne saurait justifier le recours aux « deep fakes ». Et si vraiment un acteur souhaite malgré tout développer une vidéo à base d’IA générative, alors il va falloir que le législateur s’empare du dossier. Particulièrement en rendant obligatoire l’intégration d’une mention (visible et pas en caractères 6 !) avertissant d’emblée et tout au long de la vidéo le spectateur qu’il est en présence d’un contenu fictif élaborée avec l’IA. Cela ne résoudra pas tout mais aura au moins le mérite de signaler le recours à un hyper trucage.

Sources

– (1) – Pierre-Nicolas Viger – « Le fake street marketing, la nouvelle tendance virale des marques » – Stratégies – 2 janvier 2024

– (2) – Léa D. NGuyen – « L’engouement du faux «out-of-home» – Grenier – 28 septembre 2023

– (3) – Tweet de l’auteur – 31 juillet 2023

– (4) – Bérangère Bonte – « Espace et chorizo : la « tranche » de rigolade et de lucidité offerte par le philosophe des sciences Etienne Klein » France Info – 5 août 2023

– (5) – Cyrille Dalmont – « Quand le détournement d’une vidéo de Marine Le Pen révèle les dangers de l’IA en politique » – Le Figaro – 3 janvier 2024