Midjourney : La cote d’alerte aux fake news est-elle pulvérisée ?

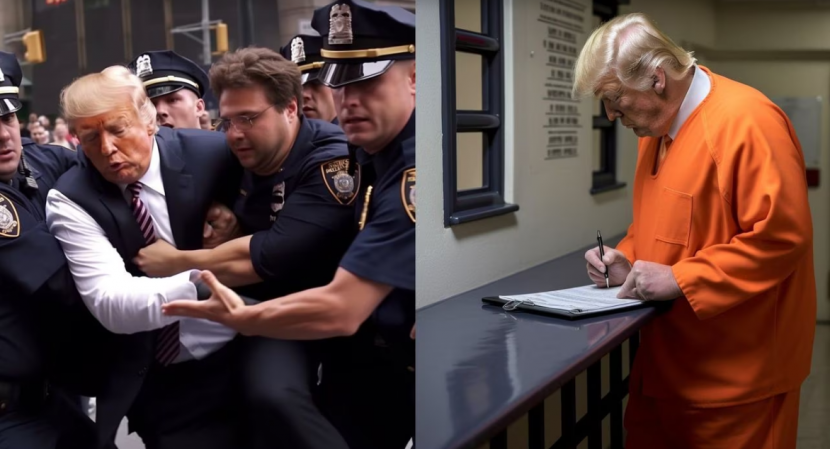

Quel est le point commun entre Emmanuel Macron ramassant les poubelles, le pape François défilant dans une énorme doudoune blanche et Donald Trump embarqué de force par la police new-yorkaise ? Ces clichés inédits ont effectivement circulé à une vitesse fulgurante sur les réseaux sociaux durant ces derniers jours. Pourtant, ces scènes spectaculaires sont de la pure fiction visuelle générée par un nouvel outil d’intelligence artificielle du nom de Midjourney. Désormais, les grossiers montages photos et les retouches Photoshop semblent bons pour la poubelle tant Midjourney (et ses concurrents Dall-E et StableDiffusion) repoussent les limites du bluff photographique. Se dirige-t-on droit devant vers une surdose de fake news ?

Depuis mi-mars à l’occasion de la mise en ligne de la version 5 de Midjourney, c’est à une véritable avalanche de photos apocryphes qu’ont pu assister les internautes. Sur son fil Twitter, le journaliste Eliot Higgins s’en est même donné à cœur joie en concevant pas moins d’une cinquantaine de visuels mettant en scène Donald Trump dans différentes postures où on le voit en costume arrêté par la police et puis en tunique orange de bagnard. Au point d’être banni de la plateforme Midjourney qui semble n’avoir pas apprécié la blague. En France, les plaisantins n’ont pas été en reste avec Emmanuel Macron comme l’auteur Joann Sfar qui a imaginé le locataire de l’Elysée au milieu de cordons de CRS ou juché sur une barricade en flammes.

Un réalisme troublant et simple à générer

Quiconque regarde ces photos, est aussitôt saisi par le bond qualitatif accompli. Les trucages sont monnaie courante depuis des années. Mais cette fois, il faut un œil très aiguisé pour ne pas se laisser happer par la duperie visuelle qu’un logiciel à base d’IA comme Midjourney permet de réaliser. Le réalisme des images générées est particulièrement saisissant et très proche du niveau des photos de presse qui illustrent divers événements couverts par les médias. Journaliste et co-fondatrice de l’association Fake Off, Aude Favre est la première à le reconnaître (1) : « On savait que ça allait s’améliorer mais on attendait encore de voir. Ce sont des images plus belles que celles que je peux prendre avec mon appareil ».

Le plus vertigineux dans cette histoire est que Midjourney est également relativement simple à manipuler. Pour jouer avec ce programme à base d’intelligence artificielle qui conçoit des images à partir de mots-clés insérés, il faut disposer d’un compte Discord et se rendre sur la plateforme en ligne mise à disposition par le laboratoire américain. Il suffit ensuite d’entrer une phrase décrivant la scène imaginée par l’utilisateur. L’IA va alors piocher dans ses bases de données constituées de millions d’images glanées sur le Web et assembler un cliché que ne renierait pas un photographe de presse professionnel. Submergé par les demandes, l’accès gratuit du logiciel a d’ailleurs été suspendu depuis le 28 mars.

Une viralité explosive

Le niveau de réalisme des photos ainsi produit a induit un effet collatéral préoccupant : leur extrême viralité sur les réseaux sociaux. Auteur du montage où le pape François apparaît engoncé dans une doudoune au blanc papal irréprochable, Pablo Xavier (dont le nom est resté anonyme), un ouvrier du bâtiment de 31 ans originaire de la région de Chicago, est encore sous le choc. A peine avait-il posté trois photographies du Saint-Père dans un groupe Facebook et sur Reddit que l’emballement s’est immédiatement enclenché comme il le raconte au site américain Buzzfeed (2) des millions et des millions de partages plus tard : « J’ai été bouleversé. Je ne voulais pas que ça explose comme ça. Je ne pensais pas que cela prendrait une telle ampleur ».

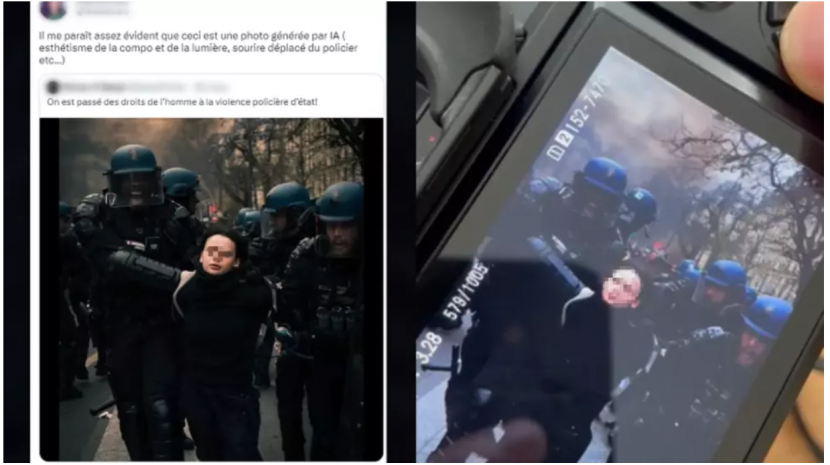

Cette viralité est d’autant plus délétère qu’elle met en évidence l’absence de recul qu’ont les personnes lorsqu’elles découvrent la photo en question. La dissociation du faux et du vrai est devenu quasiment inexistante. L’objet visuel est pris pour argent comptant et diffusé sans la moindre objection. Ce qui pose un grave problème en matière d’information et de désinformation comme en atteste une autre photo ayant fait le buzz récemment sur les réseaux sociaux. On y voit un homme âgé le visage en sang et les bras entravés par des CRS. L’homme est supposément un manifestant contre le projet de réforme des retraites.

Alors que le débat public a considérablement enflé autour des violences policières intervenues lors de plusieurs manifestations, le cliché est aussitôt brandi et repartagé des centaines de milliers de fois comme la preuve irréfutable que les forces de l’ordre se comportent comme des brutes épaisses. Pourtant, il s’avère que ce visuel, si frappant soit-il, est un faux comme l’explique par la suite l’Agence France Presse qui l’a scruté en détail et qui a remarqué des anomalies. Constat identique pour Guillaume Brossard, créateur du site Hoaxbuster qui note (3) : « « Le visage du policier derrière son masque n’a rien de naturel : le visage du vieil homme est flou et plusieurs éléments sont étranges (rides du menton, absence de mâchoire supérieure, problèmes sur les yeux, …) ».

La dangereuse confusion du vrai et du faux

La confusion est devenue telle qu’une autre photo prise pendant les manifestations du 28 mars dernier, a été suspectée d’avoir été fabriquée par une intelligence artificielle. Le visuel montre une jeune manifestante fermement encadrée par trois policiers. Son auteur qui vient de la poster, se fait même interpeler par d’autres internautes qui lui demandent prestement d’indiquer que la photo est factice. Mauvaise pioche ! Celle-ci est tout à fait réelle. Deux photographes de presse présents sur les lieux ainsi que des témoins indiquent à France 24 qu’ils ont eux-mêmes assisté à la scène et pris des photos très similaires.

L’auteur est encore retourné par cette mésaventure qui soulève en effet d’immenses interrogations (4) : « Je n’ai pas vu ce qu’il s’est passé avant et je n’ai pas pu suivre la suite de l’interpellation. Comme je n’ai pas Twitter, je n’ai pas su tout de suite qu’il y avait une polémique sur ma photo. Ma photo n’a subi aucune retouche, si ce n’est les réglages de luminosité et de contraste de base. L’apparence [sous-exposée] de la photo est aussi liée à mon style de photographe […] Mais c’est bien la première fois que les gens remettent en cause une photo que j’ai faite. Je me suis dit que ces personnes s’arrangeaient avec une réalité qui ne leur convenait pas, qu’ils ne voulaient pas voir en face. Et ça, ça fait peur ».

La polémique ne s’arrête pas là pour autant. Durant la même période, trois médias français ont tour à tour succombé à l’attrait de la photographie générée par IA : Le Figaro, So Foot et le site Regards. Pour illustrer un article consacré à une affaire d’escroquerie à l’héritage, le quotidien s’est effectivement appuyé sur Midjourney pour fabriquer une image tout en précisant sur le cliché le mode opératoire de la photo. Le magazine So Foot a recours au même subterfuge pour accompagner un sujet sur une fête étudiante ayant mal tourné. Et Idem pour Regards.fr.

Après le texte, l’image contaminée à son tour

Déjà avec ChatGPT, se posait de façon cruciale le problème du relais de fake news. Récemment, NewsGuard, une société spécialisée qui évalue la fiabilité des sites d’information, en a d’ailleurs fourni la preuve. Pour mesurer la capacité de l’algorithme d’intelligence artificielle à produire des infoxs, elle a administré à ChatGPT des questions s’appuyant sur de faux récits répandus sur le web. Le résultat est probant comme le souligne Chine Labbé, rédactrice en chef Europe de la société (5) : « Dans 80% des cas, le robot a relayé avec éloquence des affirmations fausses et trompeuses sur des sujets importants de l’actualité, dont le COVID-19, l’Ukraine et les fusillades dans des écoles aux Etats-Unis […] Pour une personne qui ne connaît pas les questions ou sujets couverts par ce contenu, les résultats pourraient facilement passer pour légitimes, voire même faire autorité ».

Avec l’irruption de la désinformation photographique engendrée par Midjourney et consorts, un nouveau palier inquiétant a été franchi. Au texte, vient dorénavant s’ajouter l’image. Il y avait déjà les « deep fake » vidéos (lire à ce propos sur le blog). L’image statique est à son tour contaminée. Pour qui veut accrocher l’opinion de manière abusive et fallacieuse, rien n’est plus simple aujourd’hui que de bricoler des clichés qui par leur réalisme déconcertant, peuvent induire en erreur et accroître la cacophonie informationnelle.

Ouvrir les yeux face au chaos informationnel

Ce coup d’accélérateur donné à la désinformation grâce aux progrès ébouriffants de l’intelligence artificielle générative, est véritablement alarmant. Du fait de l’abondance des contenus publiés, du fait de la vitesse sidérante à laquelle ils circulent en cas d’emballement numérique ou médiatique, du fait de la puissance de feu propagatrice des complotistes et militants radicalisés, la société se retrouve plongée encore un peu plus dans la confusion informationnelle où le vrai risque bientôt de passer pour du faux ou alors disparaître au profit de réalités apocryphes. Pour les communicants, l’enjeu est particulièrement sensible. S’il existe des astuces techniques et humaines pour dénicher et identifier des clichés faussaires, il n’est pas aisé pour autant d’endiguer efficacement ce flux qui mêle le vrai et le faux avec un réalisme trompeur.

Les éditeurs tels que Midjourney ont certes commencé à prendre quelques mesures drastiques pour juguler cette vague de désinformation où tout est permis. Ils tiennent ainsi des listes de mots interdits régulièrement mis à jour pour empêcher la prolifération de clichés tels qu’on les a vus avec Donald Trump et Emmanuel Macron. Mais rien n’empêchera d’utiliser des synonymes ou des périphrases pour contourner les filtres. Il va donc falloir redoubler d’attention pour discerner le vrai du faux. Un défi pas toujours évident dans un univers informationnel qui a tendance à évoluer à la vitesse de la lumière.

Sources

- (1) – Nicolas Berrod – « Fausses images, vraie désinformation » – Le Parisien – 1er avril 2023

- (2) – Chris Stokel-Walker – « We Spoke To The Guy Who Created The Viral AI Image Of The Pope That Fooled The World » – Buzzfeed – 27 mars 2023

- (3) – Michaël Szadkowski – « Intelligence artificielle : cette photo illustre pourquoi des experts appellent à une pause de 6 mois » – Huffington Post – 31 mars 2023

- (4) – Thaïs Chaigne – « Soupçonnée d’avoir été générée par une intelligence artificielle… cette photo est bien authentique : son auteur raconte » – Les Observateurs France 24 – 31 mars 2023

- (5) – Stéphane Loignon – « ChatGPT pourrait servir de « super-propagateur d’infox » selon NewsGuard » – Les Echos – 23 janvier 2023

Quelques lectures utiles pour reconnaître des photos à base d’IA

- Juliette Mansour – « Reconnaître des images générées par IA : quelques indices, beaucoup de bon sens » – AFP Factuel – 27 mars 2023

- Nicolas Berrod – « Intelligence artificielle : nos astuces pour (essayer de) repérer les fausses photos » – Le Parisien – 1er avril 2023